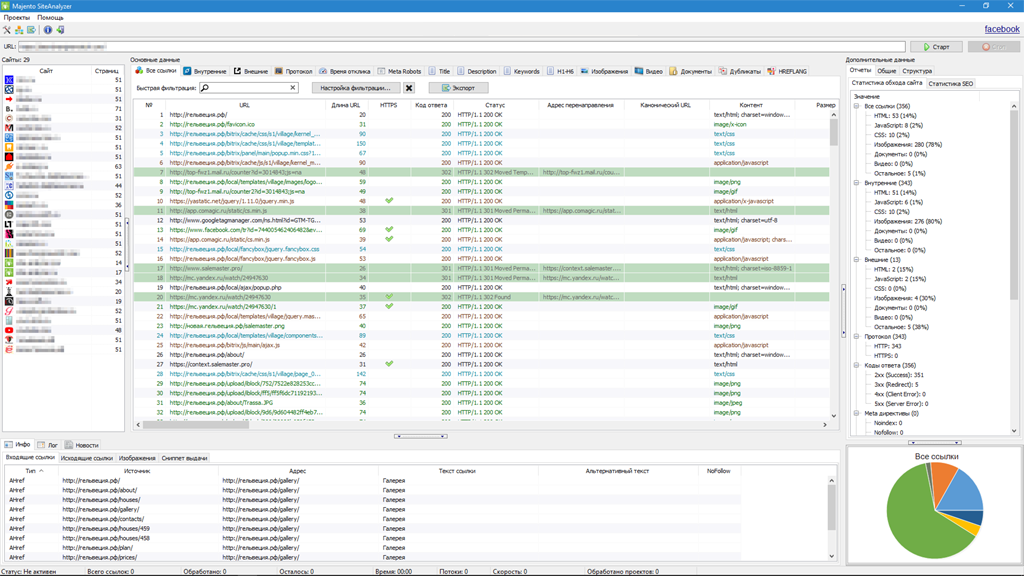

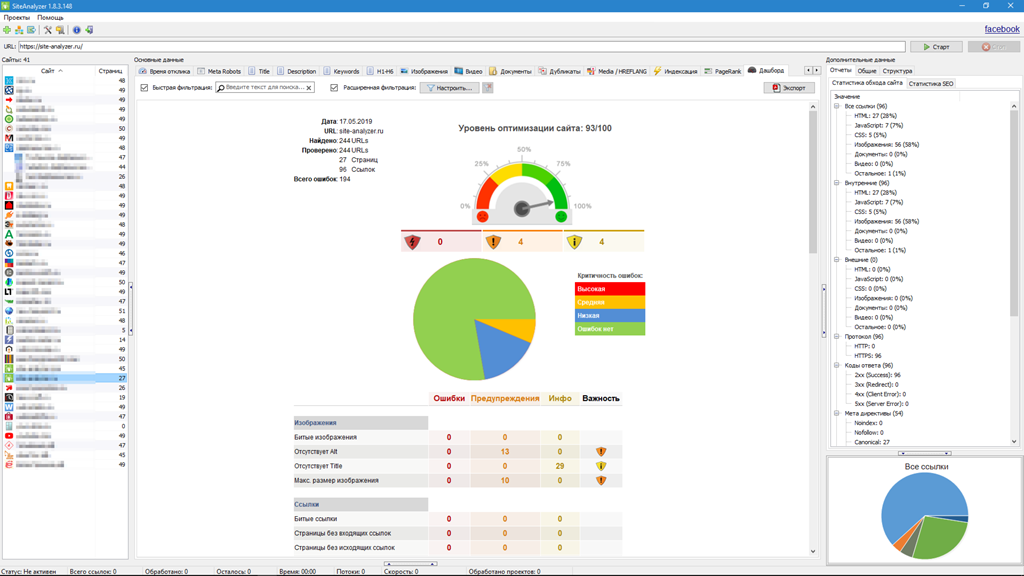

Анализ производится путем сканирования всех страниц сайта, после чего, на основе полученных данных, можно проводить аудит интересующих параметров.

Основные возможности

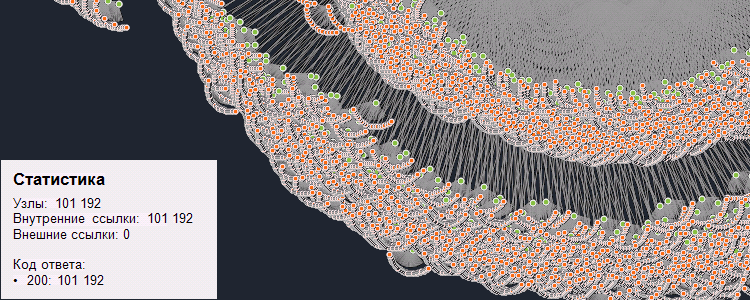

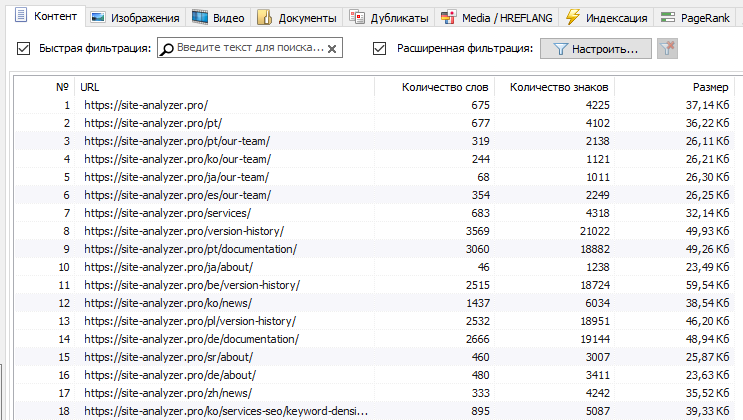

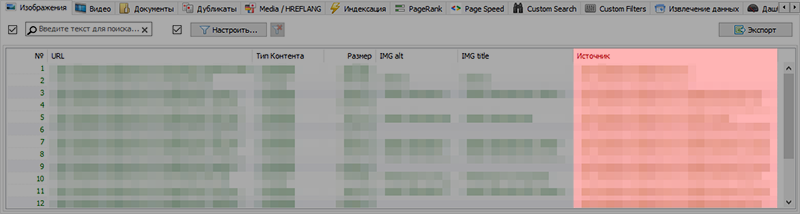

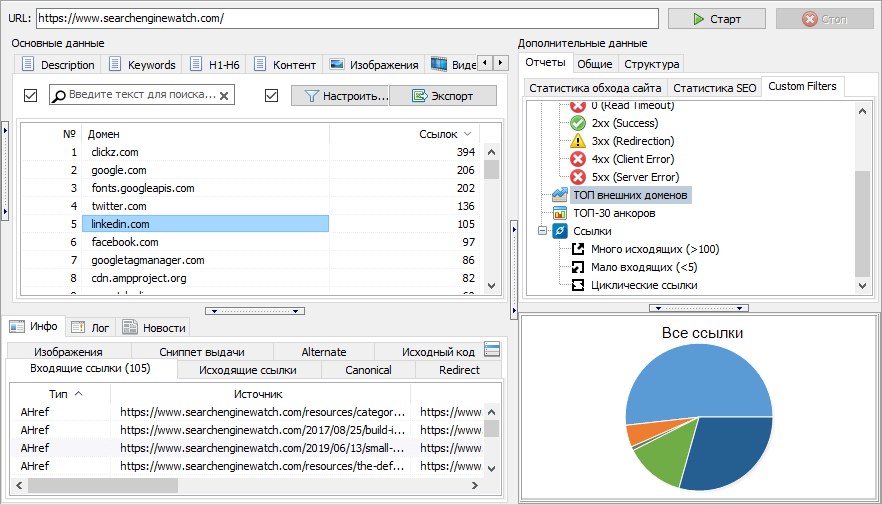

- Сканирование всех страниц сайта, а также изображений, скриптов и документов

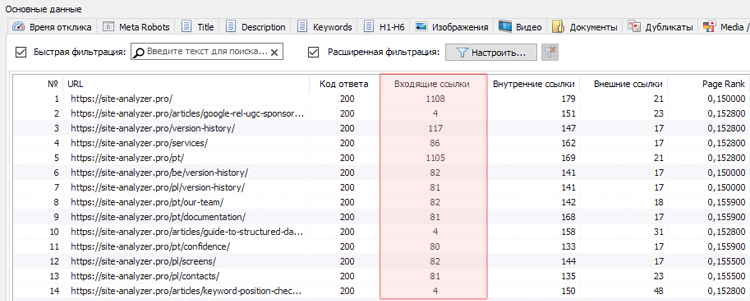

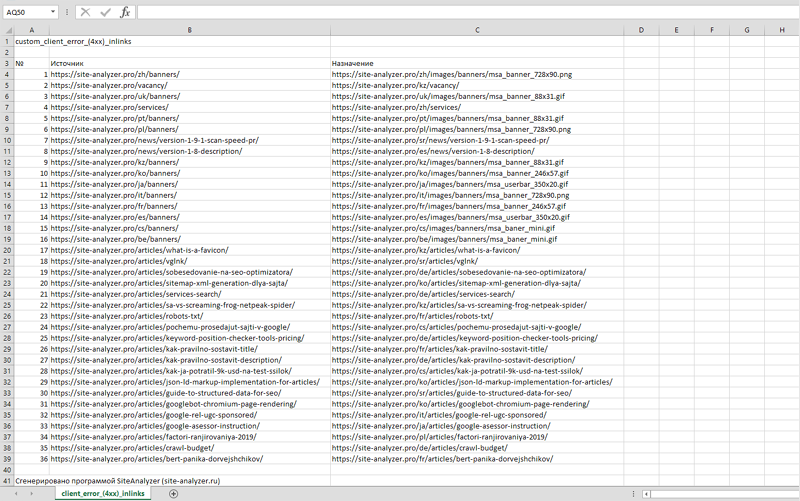

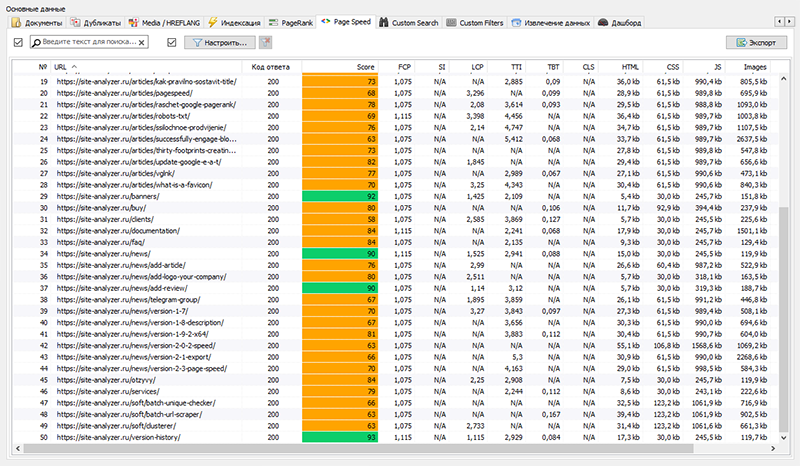

- Получение кодов ответа сервера для каждой страницы сайта (200, 301, 302, 404, 500, 503 и т.д.)

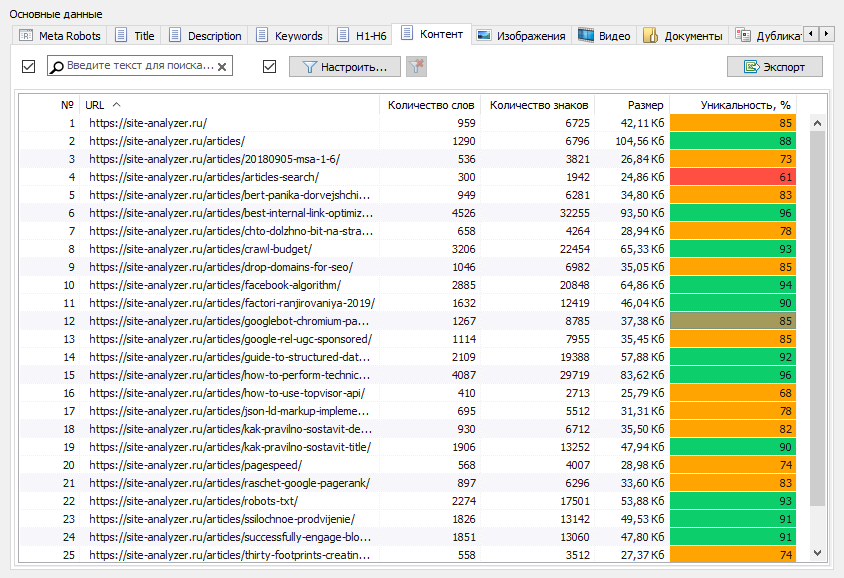

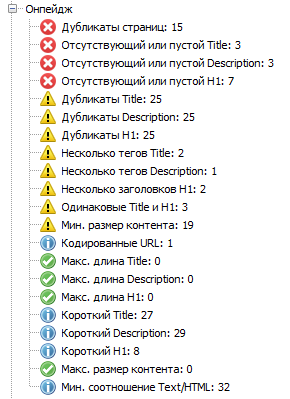

- Определение наличия и содержимого Title, Keywords, Description, H1-H6

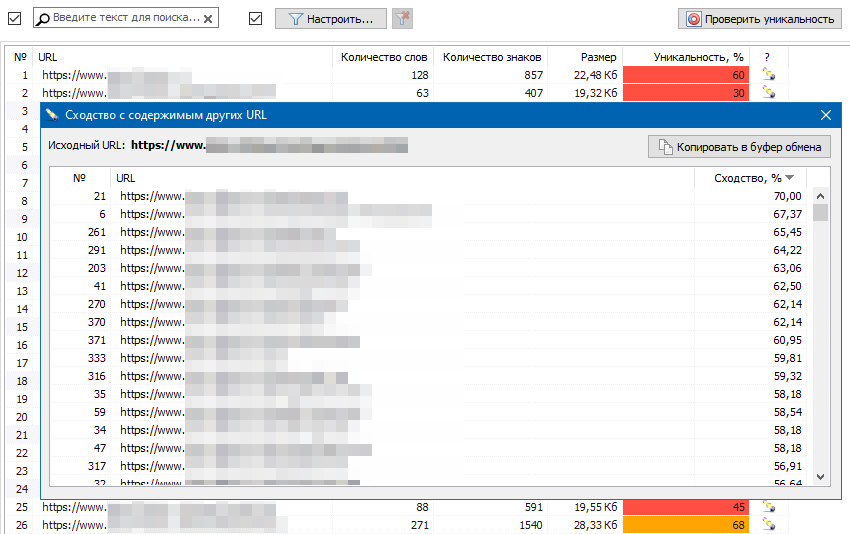

- Поиск и отображение "дубликатов" страниц, мета-тегов и заголовков

- Определение наличия атрибута rel="canonical" для каждой страницы сайта

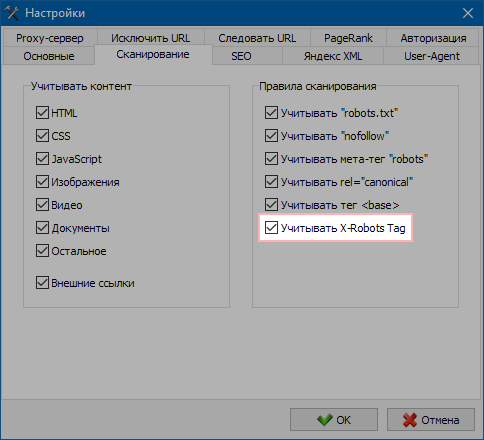

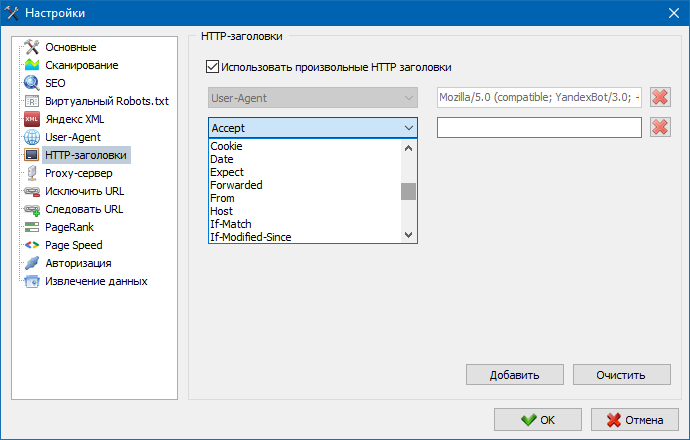

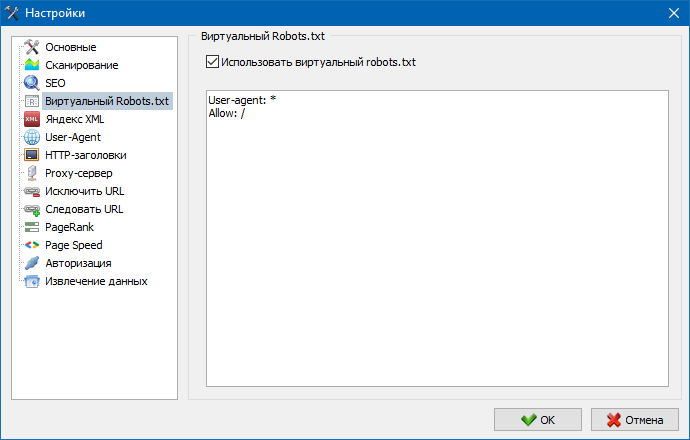

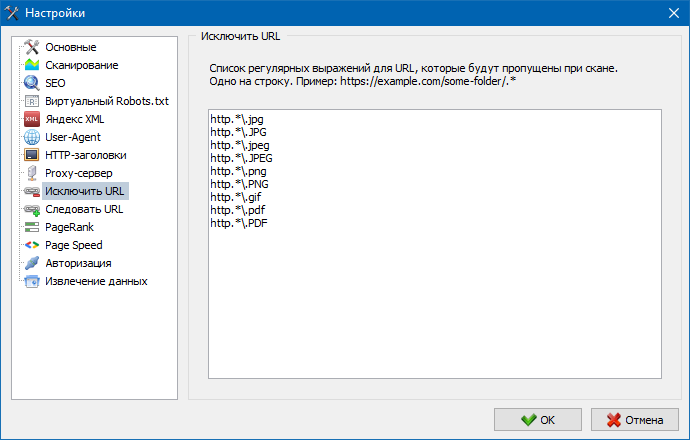

- Следование директивам файла "robots.txt", мета-тега "robots", либо X-Robots-Tag

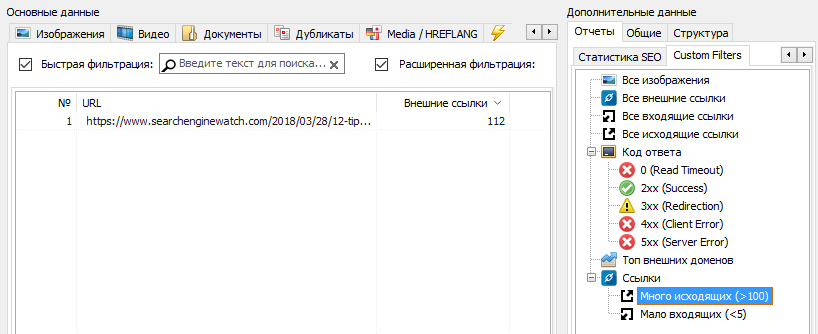

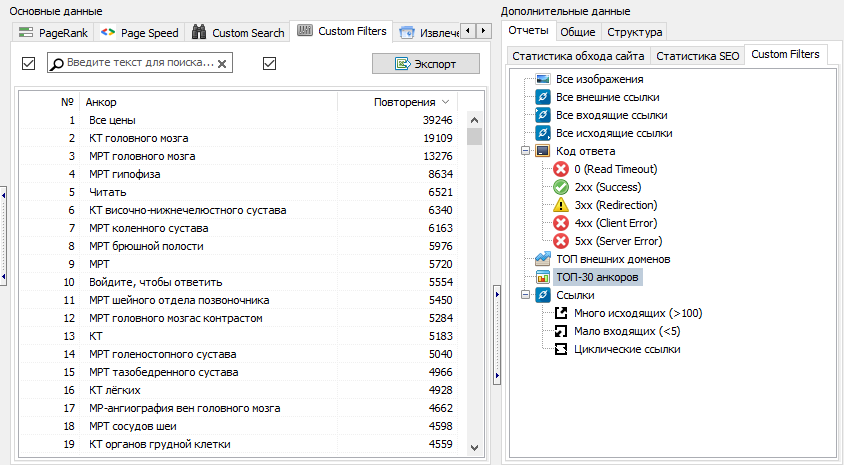

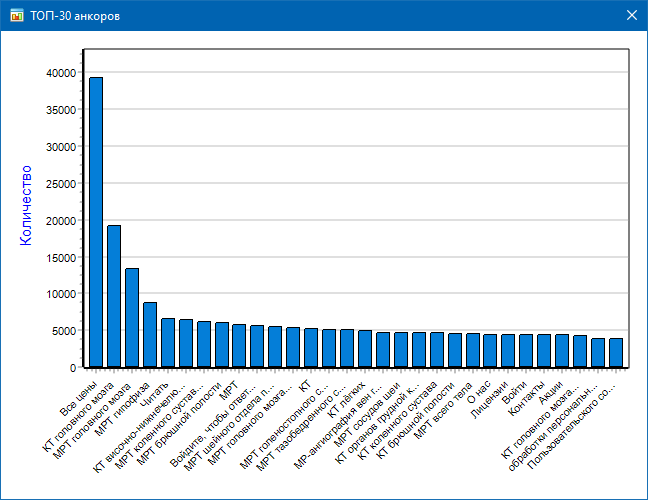

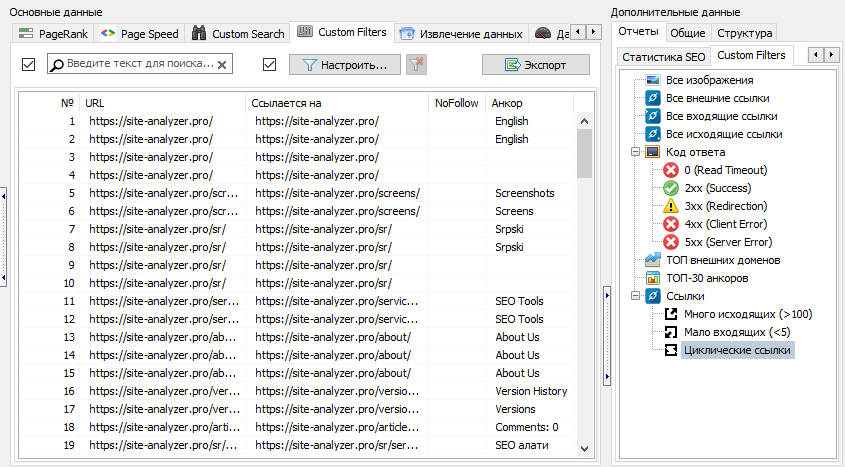

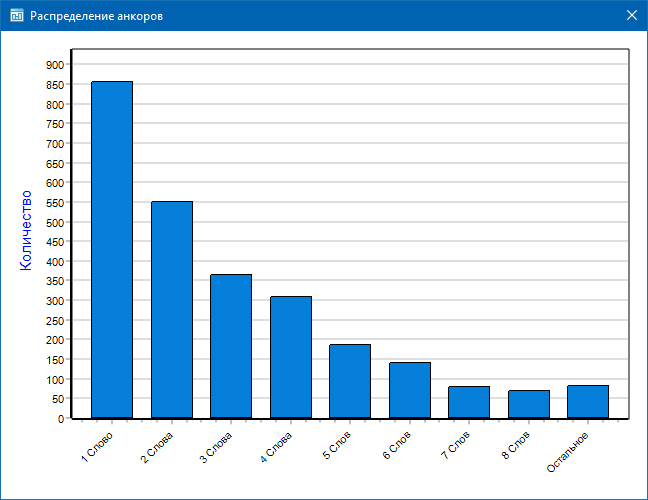

- Ссылочный анализ - определение внутренних и внешних ссылок для страницы (в пределах сайта)

- Расчет внутреннего показателя PageRank для каждой страницы сайта

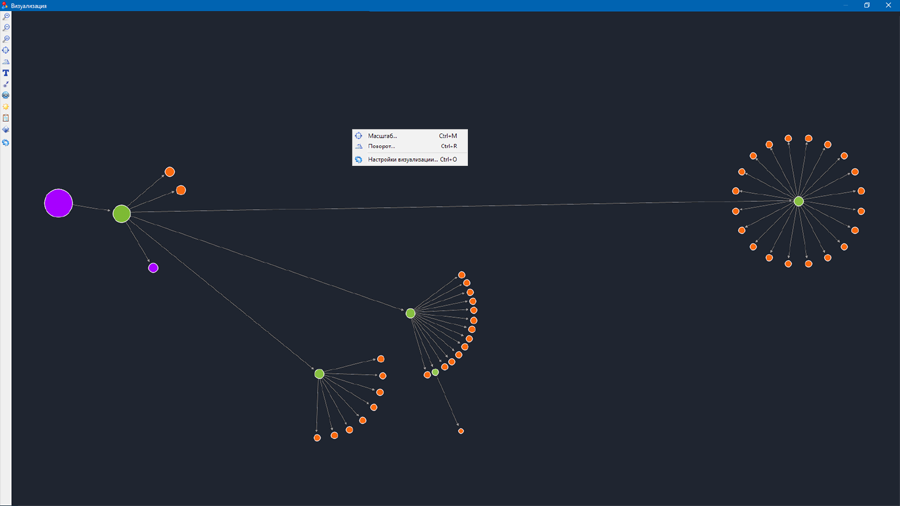

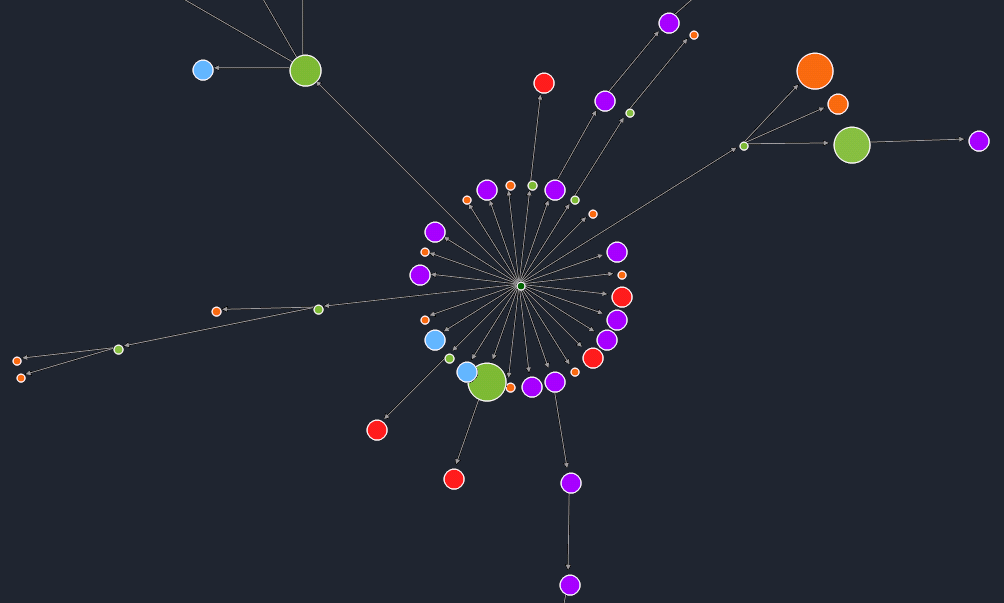

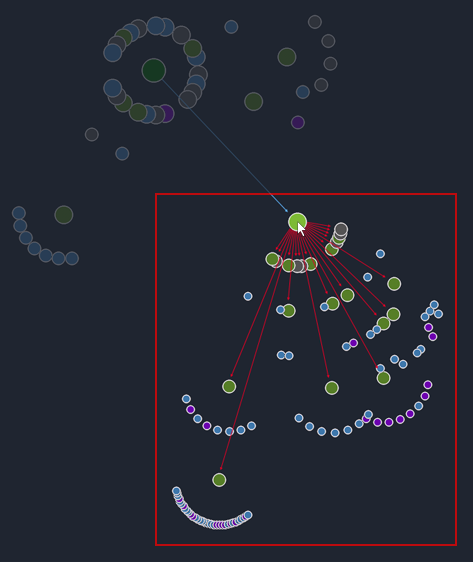

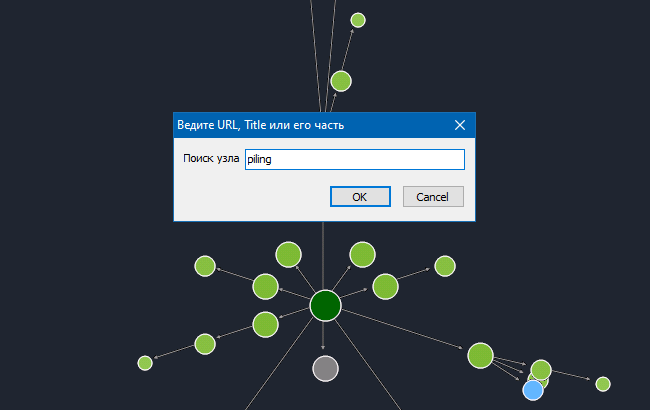

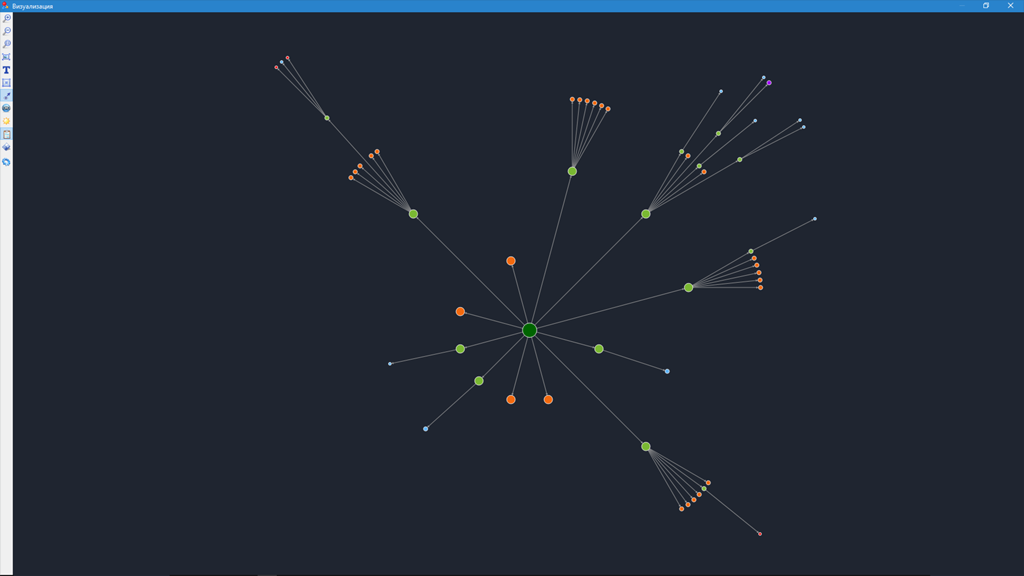

- Визуализация структуры сайта на графе

- Определение количества редиректов со страницы

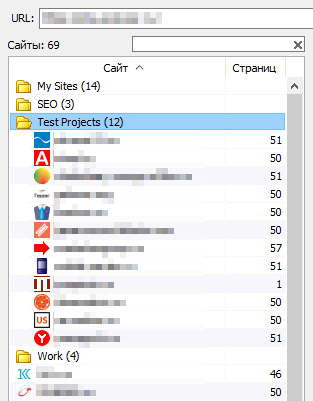

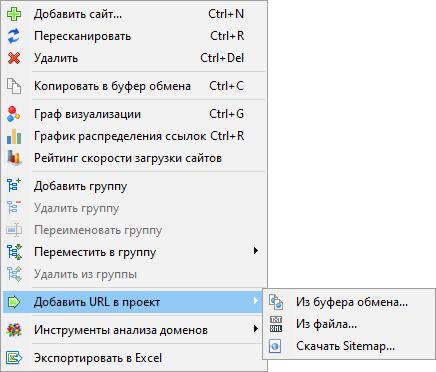

- Сканирование произвольных URL и внешних Sitemap.xml

- Генерация карты сайта "sitemap.xml" (с возможностью разбиения на несколько файлов)

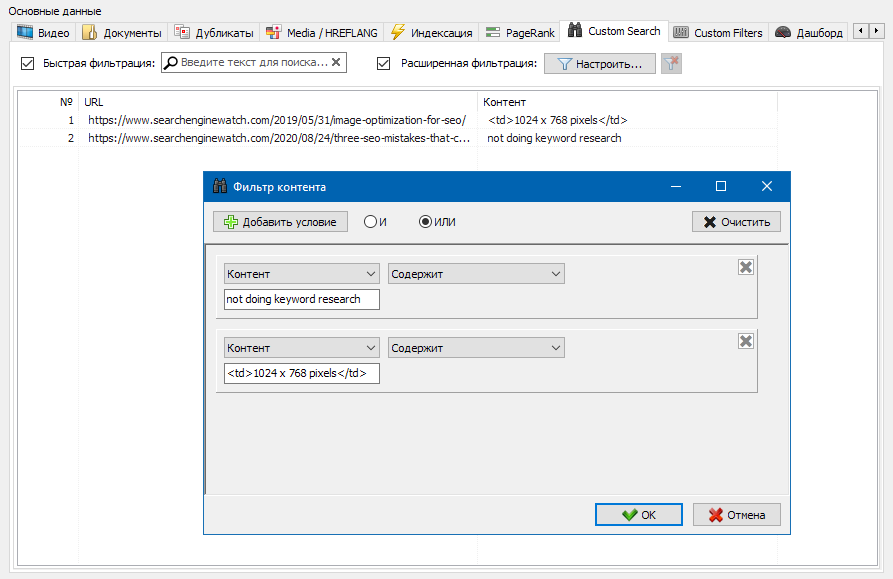

- Фильтрация данных по любому параметру

- Экспорт отчетов в CSV, Excel и PDF-формат

- Низкие требования к ресурсам компьютера, малый расход оперативной памяти

- Сканирование сайтов практически любых объемов за счет низких требований к ресурсам компьютера

- Портативный формат (работает без установки на ПК или прямо со сменного носителя)

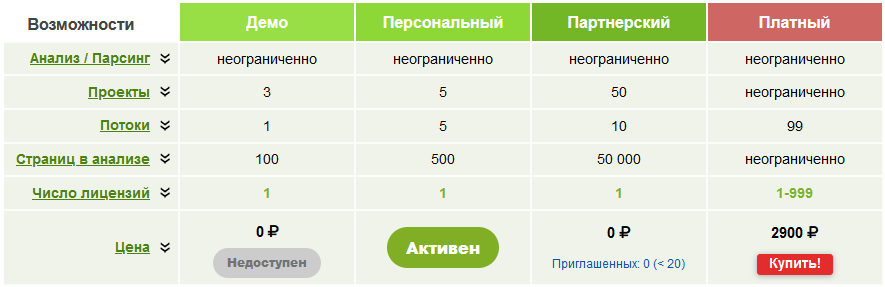

- Бесплатное распространение

Проверка на VirusTotal Ссылка

ПС. Буду рад услышать ваши замечания и предложения по развитию и работе программы.